tpwallet钱包官网下载最新2024

tokenizer分词-tokenizer分词器

解决方式之一是使用与语言相关的预分词器,如XLM,来处理SentencePiece在SentencePiece A simple and language independent subword tokenizer and detokenizer for Neural Text Processing Kudo et al, 2018中引入,提供了更通用的解决方法,将输入视为输入流,从而在字符之间添加空白符,然后调用Unigram来构建词汇。

常见的分词算法有BPEWordPieceULMBPE通过合并频率高的字符对来创建子词,如在quotFloydHubquot示例中,quotdquot和quotequot是最频繁的组合,形成quotdequotWordPiece则基于概率生成新子词,与BPE不同的是词表大小变化方向ULM则是从大词表逐渐裁剪,考虑句子多样性,生成概率分段训练tokenizer时,SentencePiece是一个。

在ES中,IK分词器是常用的中文分词器,支持自定义词库,词库热更新,无需重启集群其Analyzer ik_smart和Tokenizer ik_max_word是两种常用的分词方式ik_max_word进行最细粒度的拆分,会尽可能将文本拆分为各个可能的组合,例如quot中华人民共和国国歌quot会被拆分为quot中华人民共和国quotquot中华人民quotquot中华。

从第一部分内容可以看出Analyzer分析器由Tokenizer分词器和Filter过滤器组成ES允许用户通过配置文件elasticsearchyml自定义分析器Analyzer,如下上面配置信息注册了一个分析器myAnalyzer,在次注册了之后可以在索引或者查询的时候直接使用该分析器的功能和标准分析器差不多,tokenizer。

NLP分词算法总结分词算法在NLP中扮演关键角色,是基础任务之一分词器tokenizer的选择需考虑OOV分词粒度和歧义问题我们可以通过两种维度理解现有方法分词方法和粒度分词方法划分11 基于词典匹配如最大匹配算法正向逆向或双向最短路径算法,依赖词典,但易出现OOV和公共子串问题21 统计。

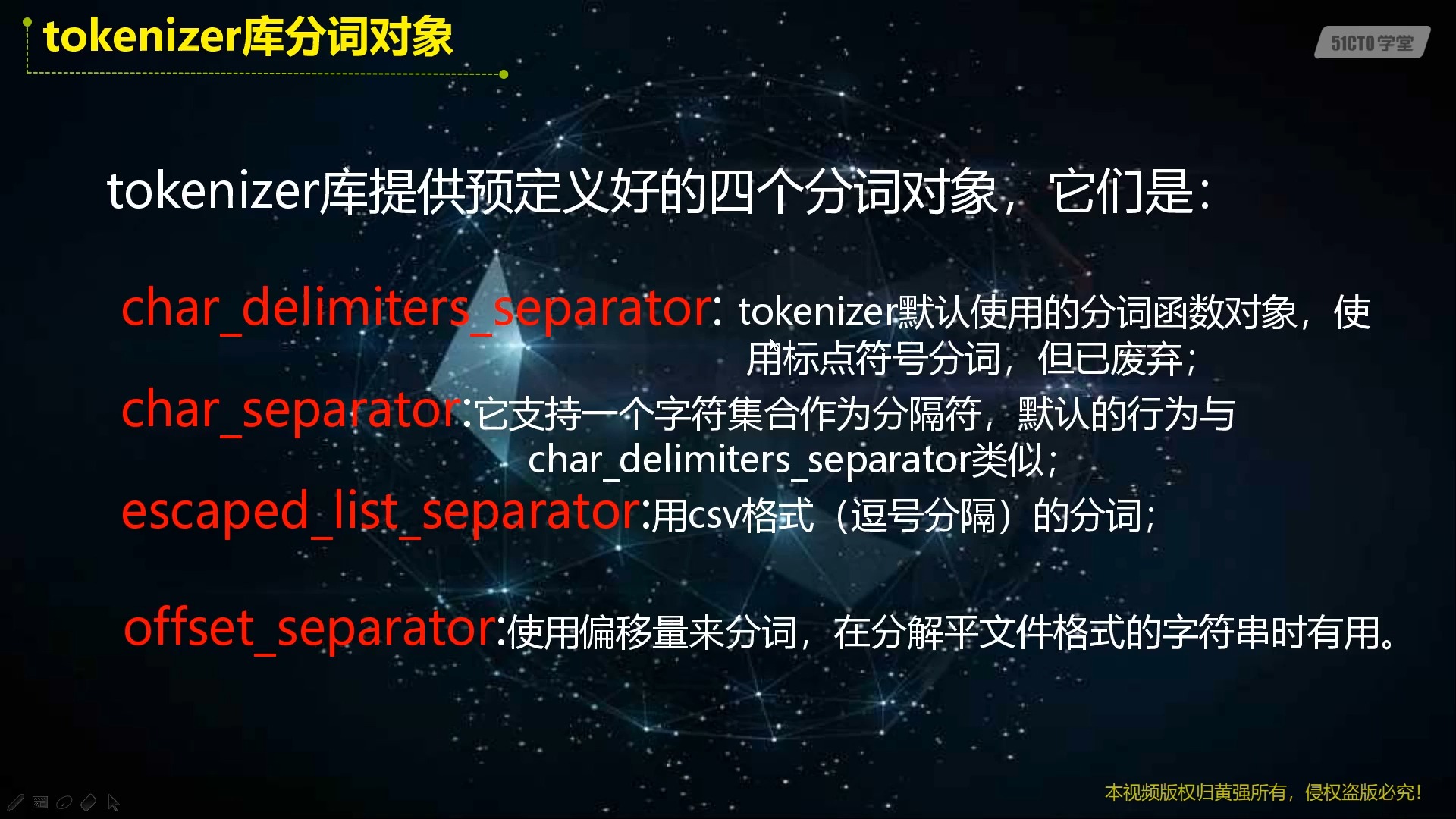

tokenizer,或称分词器,其目标是将字符序列转化为数字序列,适应模型输入不同语言的编码方式各异,例如英语通常使用GBK,中文则需UTF8分词策略依据粒度有以下几种Wordbased 每个单词分配一个ID,词汇表大小与语料相关,缺点是可能导致词义相近的词被拆分,如quotcatquot和quotcatsquotCharacterbased 分。